fofa搜索port="11434" && body="Ollama is running"

导出数据,使用批量访问脚本(可自行编写,也可使用burp爆破功能)验证可用性,具体到多少b

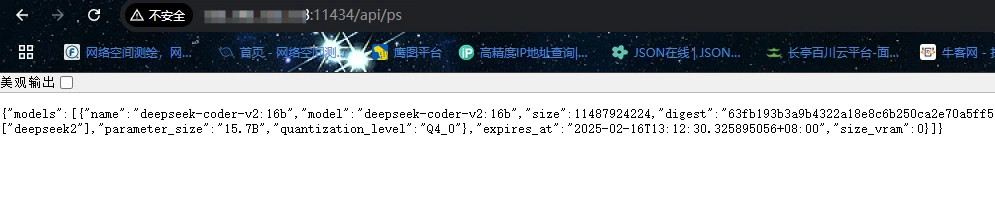

URL/api/ps为正在运行的可用模型

使用各种支持ollama api的AI软件即可开始白嫖

实测70b最多,32b其次,671b几乎没有,有的也不能用

原理:原理为随着DeepSeek突然爆火起来,ollama迎来了一大波使用量,很多人使用ollama来本地跑DeepSeek模型。但ollama接口在默认情况下不需要密钥,只需要知道接口地址便可使用正在运行的模型。有很多人在服务器上运行ollama,所以在只要知道地址和端口的情况下,便能连接ollama。通过GET请求URL:/api/ps可查看到正在运行的模型名称,如果是运行的DeepSeek模型的话,里面会包含具体多少b,实现精准白嫖